第1页 / 共4页

第2页 / 共4页

试读已结束,还剩2页,您可下载完整版后进行离线阅读

THE END

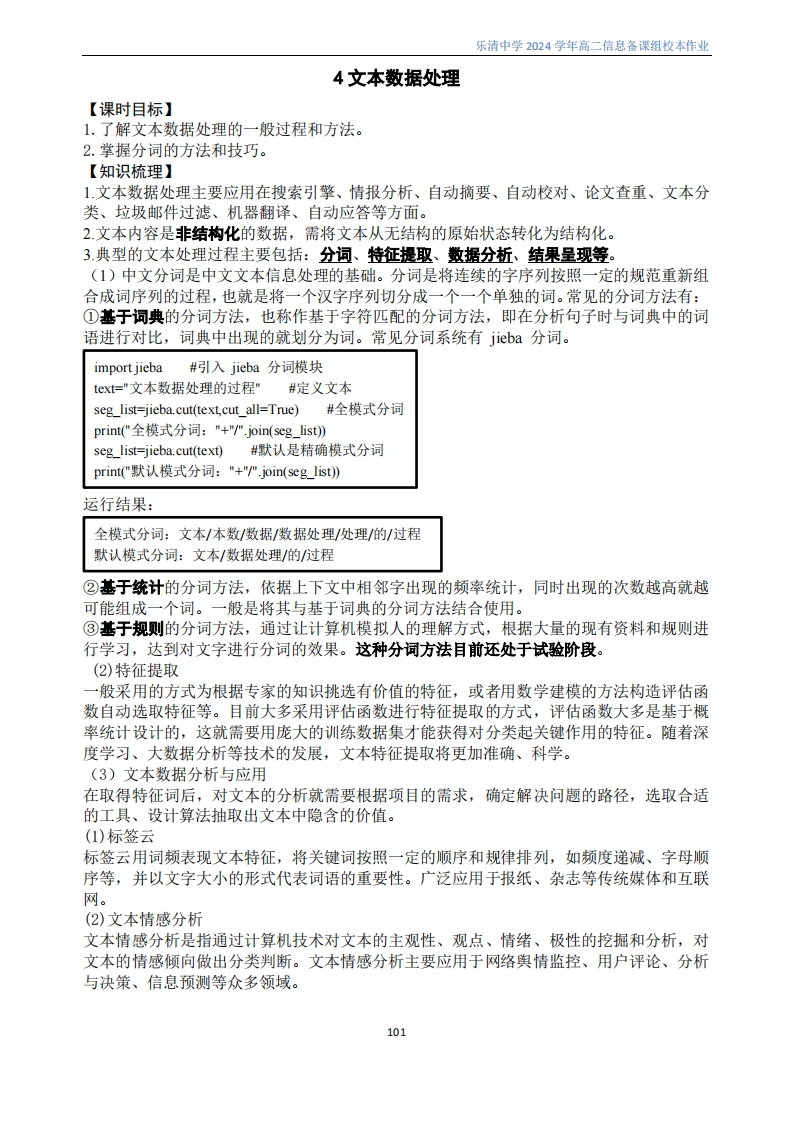

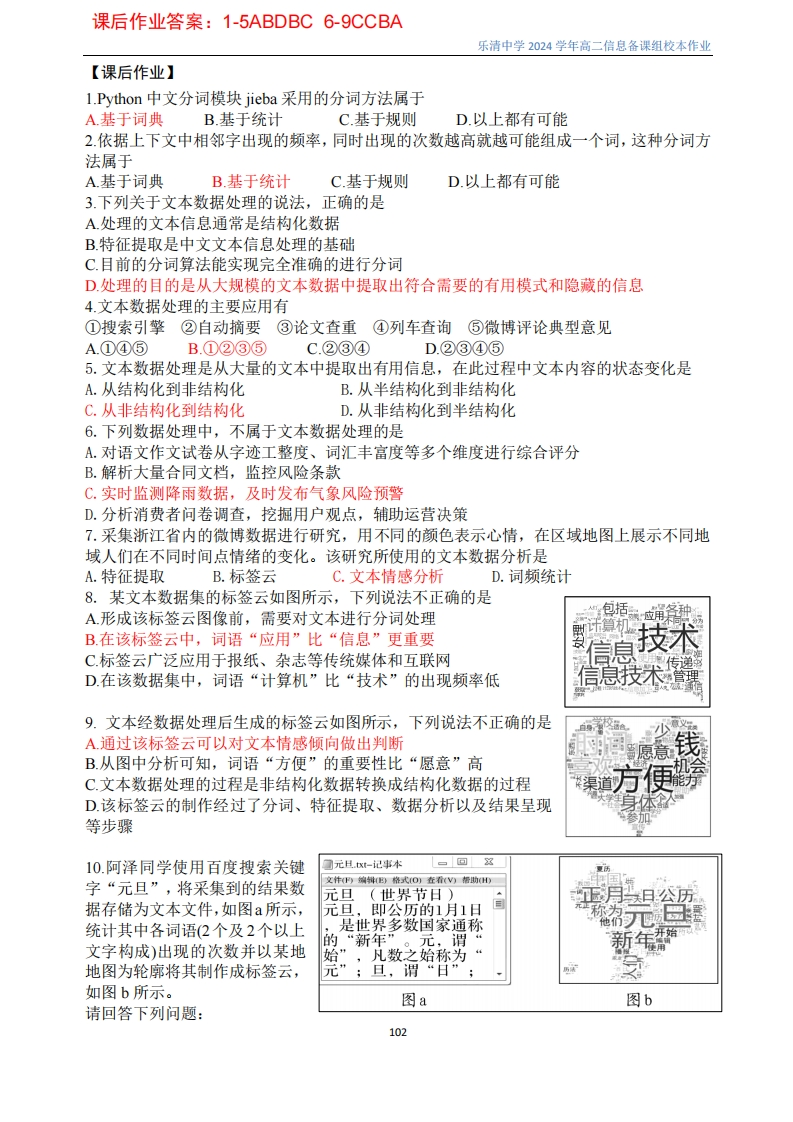

乐清中学2024学年高二信息备课组校本作业4文本数据处理【课时目标】1.了解文本数据处理的一般过程和方法。2.掌握分词的方法和技巧。【知识梳理】1.文本数据处理主要应用在搜索引擎、情报分析、自动摘要、自动校对、论文查重、文本分类、垃圾邮件过滤、机器翻译、自动应答等方面。2.文本内容是非结构化的数据,需将文本从无结构的原始状态转化为结构化。3.典型的文本处理过程主要包括:分词、特征提取、数据分析、结果呈现等。(1)中文分词是中文文本信息处理的基础。分词是将连续的字序列按照一定的规范重新组合成词序列的过程,也就是将一个汉字序列切分成一个一个单独的词。常见的分词方法有:①基于词典的分词方法,也称作基于字符匹配的分词方法,即在分析句子时与词典中的词语进行对比,词典中出现的就划分为词。常见分词系统有jieba分词。import jieba#吲l入jieba分词模块text="文本数据处理的过程"#定义文本seg_list=jieba.cut(text,cut_all=True)#全模式分词print("全模式分词:"+"/join(seg list))seg_list=jieba.cut(text)#默认是精确模式分词print("默认模式分词:"+""join(seg list)运行结果:全模式分词:文本/本数/数据/数据处理/处理/的/过程默认模式分词:文本/数据处理/的/过程②基于统计的分词方法,依据上下文中相邻字出现的频率统计,同时出现的次数越高就越可能组成一个词。一般是将其与基于词典的分词方法结合使用。③基于规则的分词方法,通过让计算机模拟人的理解方式,根据大量的现有资料和规则进行学习,达到对文字进行分词的效果。这种分词方法目前还处于试验阶段。(2)特征提取一般采用的方式为根据专家的知识挑选有价值的特征,或者用数学建模的方法构造评估函数自动选取特征等。目前大多采用评估函数进行特征提取的方式,评估函数大多是基于概率统计设计的,这就需要用庞大的训练数据集才能获得对分类起关键作用的特征。随着深度学习、大数据分析等技术的发展,文本特征提取将更加准确、科学。(3)文本数据分析与应用在取得特征词后,对文本的分析就需要根据项目的需求,确定解决问题的路径,选取合适的工具、设计算法抽取出文本中隐含的价值。(1)标签云标签云用词频表现文本特征,将关键词按照一定的顺序和规律排列,如频度递减、字母顺序等,并以文字大小的形式代表词语的重要性。广泛应用于报纸、杂志等传统媒体和互联网。(2)文本情感分析文本情感分析是指通过计算机技术对文本的主观性、观点、情绪、极性的挖掘和分析,对文本的情感倾向做出分类判断。文本情感分析主要应用于网络舆情监控、用户评论、分析与决策、信息预测等众多领域。101

请登录后查看评论内容